High-end smartphones beloven een flinke lichtsterkte, optische zoom en mooi ogende onscherpte in de vorm van bokeh. Aangezien dat puur optisch gezien niet kan, wordt daar ‘computational photography’ bij ingezet. De spiegelreflex-look wordt bij een smartphone camera gesimuleerd door algoritmes en multicamera-systemen.

De miniaturisatie van fotografie heeft zeer slimme optische constructies opgeleverd. Toch moet een lichtsterk systeem met een hoge zoomfactor net als voorheen een bepaalde lengte hebben en de lichtstralen bundelen op een sensor die groot genoeg is. Dat geldt vooral als je voor het mooie creatieve effect van onscherpte gaat, waarbij de achtergrond grotendeels vervaagt en de lichtpunten een karakteristieke schijfvormige vorm krijgen. De behuizing van een smartphone is daar echter veel te klein voor.

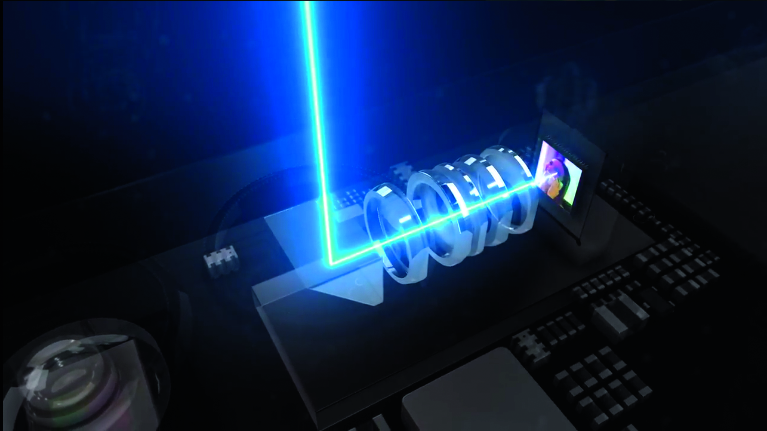

Corephotonics werkt samen met Oppo aan een vijfvoudige zoom voor smartphones. De voor een normale positionering te lange telelens ligt haaks op de groothoeklens binnen de behuizing. Een prisma buigt het licht het lenzensysteem binnen.

De fabrikanten gebruiken daarom een trucje. Ze bouwen twee of meer normale cameramodules in die het onderwerp tegelijk elk op een andere manier vastleggen. Ze gebruiken een net iets ander perspectief, een andere zoomfactor of een verschillend kleurenspectrum. Dat soort set-ups levert waardevolle informatie op die de smartphone met dank aan een aantal algoritmes slim verwerkt om diepte-informatie te achterhalen of de kwaliteit bij slechte lichtomstandigheden te verbeteren door losse foto’s over elkaar te leggen (zogeheten ‘image fusion’). Daarvoor zijn klassieke algoritmes uit de stereofotografie intensief verder ontwikkeld, geoptimaliseerd voor gebruik met smartphones en efficiënter gemaakt. Bewezen technieken op het gebied van videobewerking worden getest als alternatief of aanvulling, net als machine-learning.

De dualcamera-techniek zit vooral in de topklasse smartphones als de Google Pixel 2 (XL), Apple iPhone X en de Samsung Galaxy S9+. De Huawei P20 Pro doet daar nog een schepje bovenop met maar liefst drie camera’s. Samsung heeft ook al een model met vier camera’s. De start-up Light sleutelt aan een smartphone met negen camera’s.

Fabrikant Light heeft recent een prototype van een smartphone met negen camera’s gepresenteerd. Dit systeem heeft een resolutie van 64 megapixels en biedt als het goed is een goede beeldkwaliteit bij slecht licht.