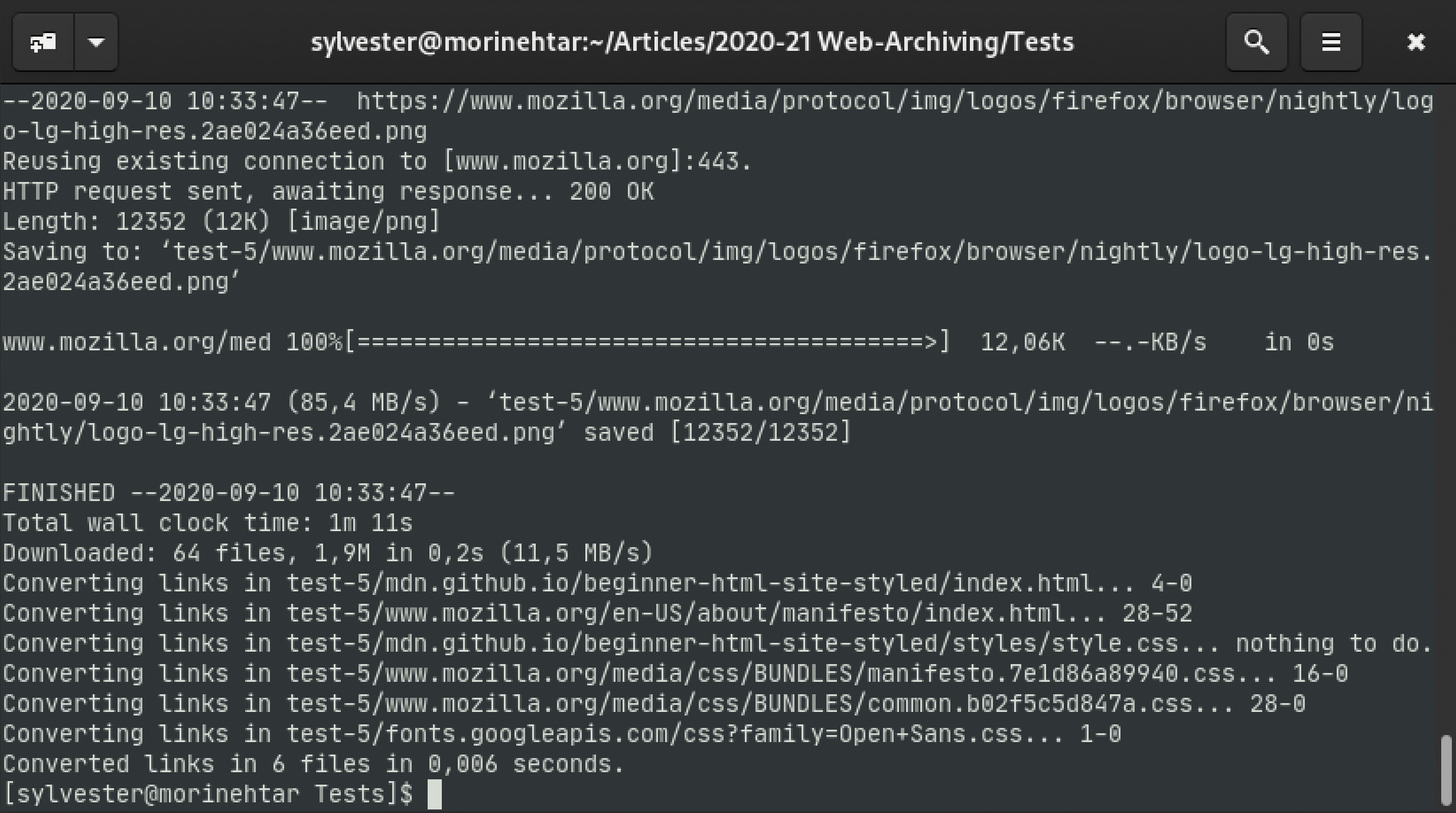

Wil je een kopie maken van een webpagina of meerdere webpagina’s? Met behulp van wget kun je zelfs hele websites downloaden, maar pas wel op dat je niet teveel downloadt. Met de volgende instructies zorg je dat je een goede kopie maakt en probeert je pc niet het hele internet te downloaden.

Om een kopie te kunnen maken hoef je alleen maar de website te kunnen openen – net zoals elke bezoeker. Om de pagina(‘s) volledig op te slaan, gebruik je wget. Vrijwel elke Linux-distributie heeft dat in zijn pakketbronnen en voor Windows heeft het project een installer en is er een macOS pakket.

Het beschrijven van alle functies en parameters van wget gaat te ver, de tool is als een Zwitsers zakmes. Hieronder beschrijven we de belangrijkste instellingen voor het klonen van een website.

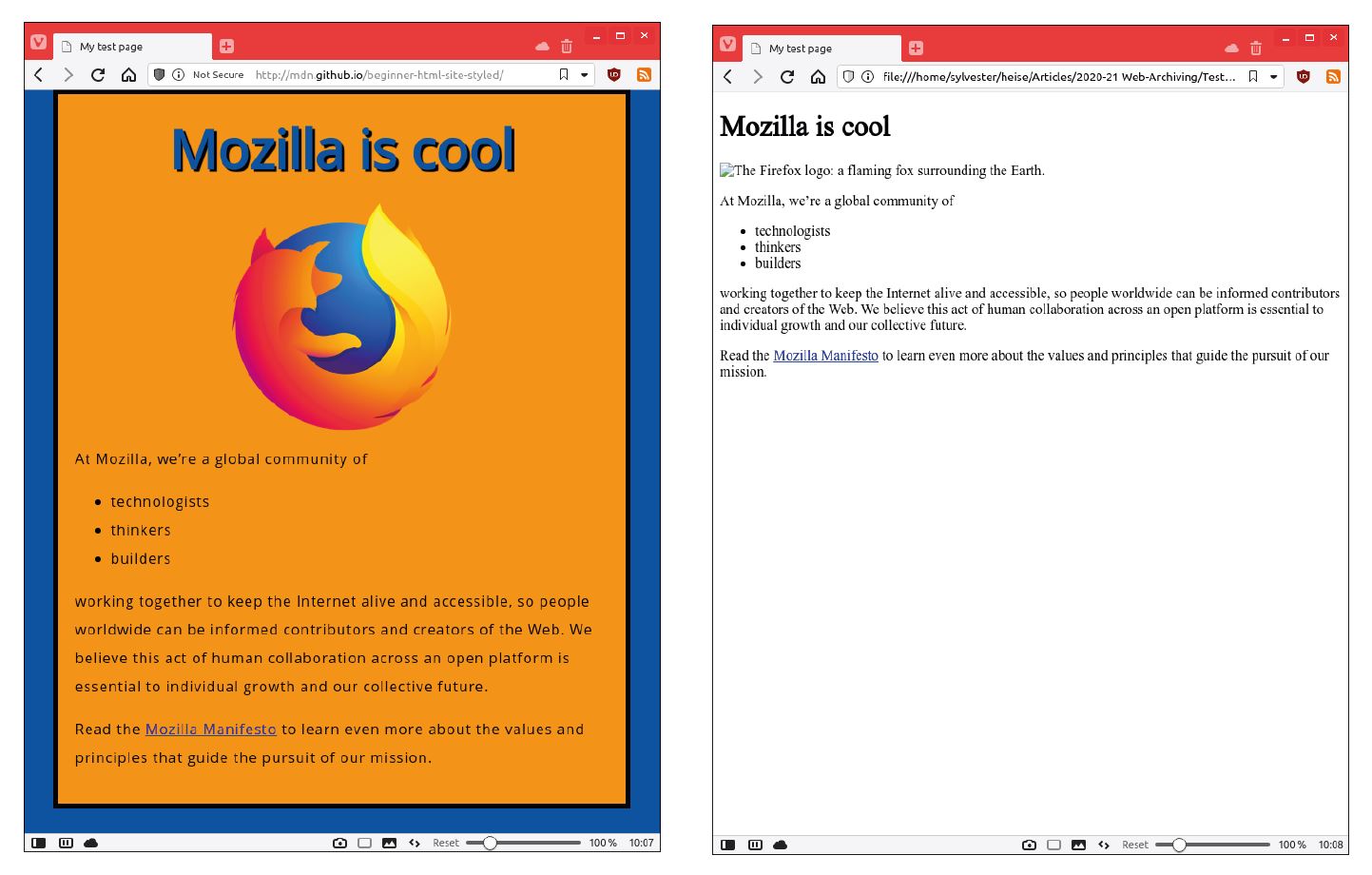

Als voorbeeld en om zelf te oefenen is de ‘Beginner HTML Site’ van Mozilla goed geschikt, die je vindt op https://mdn.github.io/beginner-html-site-styled/.