Dit is waarom AI zo vaak én zoveel verkeerde info geeft

Onjuiste informatie, scheve verbanden en zelfs verzonnen bronnen — het blijft een hardnekkig probleem dat AI-modellen niet weten op te lossen. Zelfs bij nieuws ontsporen ze geregeld: overtuigend in toon, maar vaak loos in inhoud.

Lees verder na de advertentie

AI hallucineert en niemand heeft een oplossing

Dat kunstmatige intelligentie hallucineert en fouten maakt, is al langer bekend — en evenzeer dat de aanbieders van zulke systemen daar nog altijd geen afdoende oplossing voor hebben. Hoe vaak antwoorden feitelijk onjuist blijken, vooral bij nieuwsgerelateerde vragen, toont nu een nieuwe studie van de European Broadcasting Union (EBU). Daaruit blijkt dat één op de drie antwoorden van gangbare chatbots fouten bevat. De oorzaken lopen uiteen, maar delen één constante: er is nog geen structurele manier gevonden om ze te verhelpen.

Tip

Met connectiviteit van Odido Business maakt Firefly verlichting slimmer, efficiënter en beter beheersbaar.

Niet alleen verzonnen feiten, maar ook fictieve bronnen

Opvallend is dat het niet alleen om verzonnen feiten gaat — volgens het onderzoek waren ook de opgegeven bronnen vaak volledig gefabriceerd. Dat maakt controle door gebruikers nagenoeg onmogelijk. Wel constateert de studie een lichte verbetering ten opzichte van een eerdere meting: het aandeel foutieve antwoorden daalde van ongeveer de helft naar zo’n 37 procent. Getest werden Copilot, ChatGPT, Perplexity en Gemini.

Altijd op de hoogte van kunstmatige intelligentie?

Verrassend slecht resultaat voor Gemini

Gemini scoorde daarbij verrassend slecht — juist van Google zou je wellicht meer verwachten. De chatbot bouwt immers op zowel realtime zoekresultaten als de Knowledge Graph, en Google heeft als geen ander ervaring met het ordenen van webinformatie. Toch is Gemini niet te vergelijken met de AI-overzichtsfunctie of de AI-modus in de zoekmachine zelf — die zouden volgens de onderzoekers vermoedelijk beter presteren.

Fouten in bijna de helft van alle antwoorden

Van alle antwoorden bevatte 45 procent minstens één fout — in 31 procent van de gevallen ging het om een verkeerde of verzonnen bron. Volgens de auteurs is dat vooral problematisch voor uitgevers, wanneer hen uitspraken of artikelen worden toegeschreven die niet van hen afkomstig zijn. Aan het onderzoek, uitgevoerd onder leiding van de BBC, namen 22 publieke omroepen deel uit 18 landen, samen goed voor 14 talen.

Waarom AI verkeerde verbanden legt

De oorzaken van zulke fouten liggen in de modellen zelf — ze leggen soms verbanden die logisch lijken, maar feitelijk niet kloppen. Zo maakte een chatbot ooit van een rechtbankverslaggever een moordenaar, simpelweg omdat namen en artikelen in de trainingsdata dicht bij elkaar stonden. AI redeneert immers niet, maar voorspelt woorden op basis van waarschijnlijkheden en statistische nabijheid.

Omdat begrippen als artikel, verslaggever en gebeurtenis niet echt worden begrepen, ontstaan verkeerde koppelingen. Eén en één kan bij AI zomaar drie worden — en tellen blijft al helemaal een probleem. Dat een model het juiste aantal e’s in aardbei weet te plaatsen, komt doordat het dat patroon ergens heeft aangetroffen, niet omdat het begrijpt hoeveel e’s erin horen.

Slechte trainingsdata versterken het probleem

Een tweede bron van fouten ligt in de trainingsdata zelf — die bevatten vaak al onnauwkeurigheden. Wat daarin scheef staat, neemt het model één op één over. Zelfs een subtiel vertekende weergave kan genoeg zijn om tot verkeerde conclusies te leiden. Voor het trainen wordt vrijwel alles gebruikt wat online beschikbaar is, waarna klikwerkers de data schonen en schadelijke inhoud markeren.

Een psychisch belastende taak, gezien het materiaal dat zij dagelijks moeten doorploegen. Het bedrijf Mercor laat wereldwijd zo’n 30.000 mensen dit werk doen en wordt inmiddels op 10 miljard dollar gewaardeerd. Tot de klanten behoren OpenAI en Anthropic. Meta werkt met Scale AI — een bedrijf waarin het ook zelf heeft geïnvesteerd.

De drang om altijd een antwoord te geven

AI-modellen zijn ontworpen om altijd een antwoord te geven — en liefst een dat de gebruiker tevreden stelt. Liever iets verzinnen dan toegeven dat ze het niet weten: een menselijk aandoende reflex, maar puur het gevolg van hun trainingsdoelen. Modellen worden immers beloond voor antwoorden die juist lijken, niet voor terughoudendheid. Dat verbetert de trefzekerheid bij eenvoudige vragen, maar voedt tegelijk de neiging tot overmoed — de ‘drang om te behagen’ die onjuiste informatie in de hand werkt. Het is als iemand die bij een meerkeuzetoets liever iets aankruist dan de vraag openlaat: niets invullen is zeker fout, een gok kan nog goed uitpakken.

Groot vertrouwen in AI onder jongere gebruikers

In een tweede onderzoek ontdekte de BBC dat meer dan een derde van de Britse volwassenen AI volledig vertrouwt — bij de onder-35-jarigen zelfs de helft. Opvallend is ook dat gebruikers bij foutieve informatie niet alleen de chatbots verantwoordelijk houden, maar ook de gelinkte bronnen — zelfs wanneer die inhoudelijk niets met de fouten te maken hebben.

Altijd op de hoogte van kunstmatige intelligentie?

Meer verantwoordelijkheid en controle gevraagd

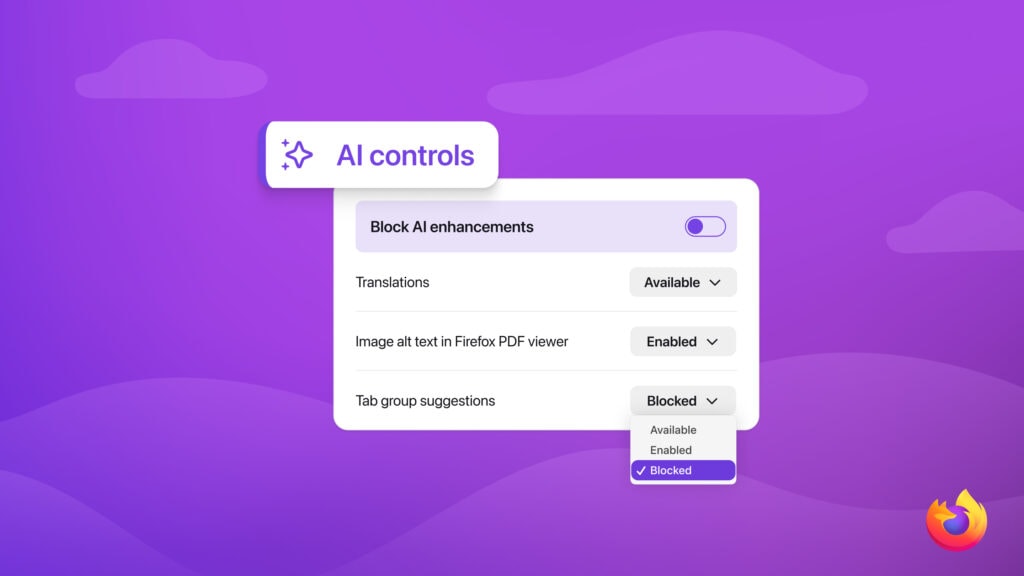

De auteurs van de studie vinden dat aanbieders van AI-systemen het probleem van foutieve informatie — en de daaruit voortvloeiende geloofwaardigheid van chatbots — veel serieuzer moeten nemen. Ook pleiten ze voor meer controle voor uitgevers over hoe hun content wordt gebruikt, bijvoorbeeld via een uniforme citatiestandaard.

Tegelijk stellen ze de vraag hoe AI-aanbieders verantwoordelijk kunnen worden gehouden voor de output van hun modellen. Dat blijkt lastig, omdat antwoorden niet reproduceerbaar zijn: een chatbot die vandaag zegt dat een banaan blauw is, hoeft dat morgen niet te herhalen. In theorie kun je het model corrigeren — “banaan = blauw” is onjuist — maar het risico bestaat dat het systeem daarna elk gesprek over bananen mijdt. Controle blijft dus beperkt en onvoorspelbaar.

Tot slot

De auteurs van het onderzoek benadrukken dat gebruikers beter moeten begrijpen hoe kunstmatige intelligentie werkt — niet als kennissysteem, maar als taalmodel dat waarschijnlijkheden voorspelt. AI redeneert niet, ze berekent patronen, en kan daardoor met grote zekerheid onzin produceren. Wie dat mechanisme doorziet, herkent fouten sneller en beoordeelt bronnen kritischer. Zonder dat inzicht blijft de verleiding groot om AI-antwoorden als waar aan te nemen — terwijl ze dat zelden zijn.

Tip!

Dit is het moment om jouw droomdevice aan te schaffen.

Meer over

Praat mee

- AI hallucineert en niemand heeft een oplossing

- Niet alleen verzonnen feiten, maar ook fictieve bronnen

- Verrassend slecht resultaat voor Gemini

- Fouten in bijna de helft van alle antwoorden

- Waarom AI verkeerde verbanden legt

- Slechte trainingsdata versterken het probleem

- De drang om altijd een antwoord te geven

- Groot vertrouwen in AI onder jongere gebruikers

- Meer verantwoordelijkheid en controle gevraagd

- Tot slot

Lijkt er wel op alsof AI getraind wordt met data van politieke inhoud…