Kunstmatige intelligentie en praktische problemen

In de race van de mens tegen de artificiële intelligentie (AI) slaat Homo sapiens bijna dagelijks een toch wel treurig figuur. Toch zijn de meeste succesverhalen oppervlakkig en wordt verzwegen waar er overal nog problemen zijn bij kunstmatige intelligentie. Er zijn nog zoveel vragen waarop de technologie van vandaag geen antwoord heeft.

Lees verder na de advertentie

De droom dat de techniek qua intelligentie gelijk of zelfs superieur is aan mensen, leek nog nooit zo dichtbij. Algoritmes herkennen niet alleen objecten in foto’s, maar fungeren ook als personal assistant, verslaan de wereldkampioenen in strategiespellen die veel te complex zijn voor normaal begaafde mensen, en componeren, schilderen en schrijven verhalen.

Vaak hebben ze zelfs geen menselijke voorbeelden meer nodig. De nieuwste versie van AlphaGo van Google-dochter Deepmind heeft het Aziatische bordspel Go niet zoals voorheen gebruikelijk geleerd door menselijke matches te bestuderen, maar van de grond af aan door met een kloon van zichzelf te trainen.

Kunstmatige naïviteit

Tip

Met IoT-oplossingen van Odido Business beheert Landal de verwarming van vakantieparken efficiënter en duurzamer.

Maar niet elke harde training verhoogt de intelligentie. Kunstmatige neurale netwerken maken soms fouten die er zo dom uitzien dat een menselijke toeschouwer daar gewoon niets van begrijpt. Veel fouten zijn grappig. Er zijn hele blogs aan gewijd, met bijvoorbeeld de geniaal mislukte face-swap-AI die het gezicht van een baby verving door de draaiknoppen van een fornuis in plaats van door het gezicht van de vader. Andere hebben ernstigere gevolgen, zoals AI-systemen voor sollicitatiebeheer, en natuurlijk autonome voertuigen die een verkeerssituatie verkeerd beoordelen.

Terwijl wetenschappers nog steeds intensief op zoek zijn naar manieren om de besluiten van machinaal getrainde systemen transparanter te maken, lopen er in de praktijk al jaren intensieve tests, zoals een blik naar de VS leert. Algoritmes geven daar sociale voorspellingen over daders en selecteren sollicitanten, vaak ten nadele van sociaal zwakkere groepen. Critici vrezen daarom dat zwaar bevochten verworvenheden als de gelijke behandeling van mensen ongeacht geslacht en herkomst, door de zogenaamd neutrale techniek zachtjesaan weer verloren gaat.

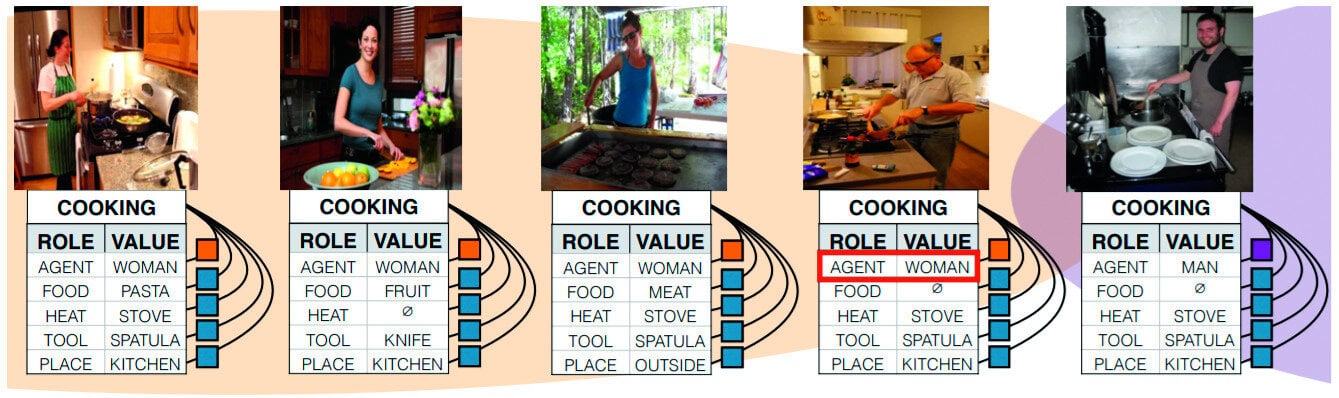

Dat kunstmatige neurale netwerken niet steeds de resultaten leveren die mensen verwachten, heeft verschillende oorzaken. De fout ligt vaak bij de trainingsgegevens die het netwerk niet helpen om juist die vaardigheden te trainen die het nodig heeft om het probleem op te lossen.

Maar het ligt ook aan de architectuur zelf, die nog niet bij benadering gelijk is aan de complexe interactie tussen menselijke neuronen en synapsen. Daarom leren mensen veel efficiënter dan een AI, denken ze in logische samenhangen in plaats van alleen in patronen en kunnen ze omgaan met humor en schijnbare onzin. Een machinaal getraind beeldherkenningssysteem kan echter volledig van slag raken door vreemde scènes. Als je bijvoorbeeld een giraf in een woonkamerfoto monteert, lijdt de nauwkeurigheid van de objectdetectie daaronder.

Kunstmatige vooroordelen

Alleen als een steekproef groot genoeg is en de betreffende categorie in al zijn facetten vertegenwoordigt, helpen die gegevens een neuraal netwerk karakteristieke kenmerken en patronen te vinden en deze het juiste gewicht te geven. Afhankelijk van het toepassingsgebied kan het eenvoudig, nogal lastig of gewoon onmogelijk zijn om een kwalitatief hoogwaardige en uitgebalanceerde steekproef te krijgen die groot genoeg is.

Bij de beroemde kattendetector van Google werkte dat perfect, maar bij foto’s van mensen begonnen de problemen al. Toch is er op het internet bepaald geen tekort aan foto’s waar mensen op staan. Het probleem is dat in die enorme collectie foto’s, mannen met een lichte huid domineren en gekleurde mensen sterk ondervertegenwoordigd zijn. Als een provider bijvoorbeeld de eerste 100.000 resultaten van de fotozoekvraag ‘mens’ neemt en zijn kunstmatig neuraal netwerk daarmee traint, vat dit de lichte huidskleur ten onrechte op als een van de belangrijkste kenmerken van een mens. Als het systeem ook wordt getraind in het detecteren van gorilla’s, zal het netwerk een zwart gezicht beschouwen als een zeer sterke indicatie van een gorilla. De ‘racistische’ AI is daarmee geboren.

Die blooper overkwam Google bij de automatische trefwoordentoekenning in de clouddienst Google Foto’s, maar ook de gezichtsherkenningssoftware van Microsoft en IBM liet in een studie van de onderzoekster Joy Buolamwini (MIT Media Lab) hogere foutpercentages zien bij mensen met een donkere huidskleur. Overigens worstelt Google nog steeds met dat probleem. De categorieën ‘gorilla’ en ‘aap’ zijn al drie jaar uitgeschakeld, in plaats daarvan laat Google een pedagogisch waardevolle verklarende video zien die begrip vraagt voor het verschijnsel van steekproefvertekening.

Video van Google over bias en machine learning.

Dergelijke verstoringen noemen we een vooroordeel of bias. In het beste geval is een bias eenvoudig te herkennen en snel te verhelpen. In het ergste geval wordt hij te laat herkend, bijvoorbeeld wanneer de AI al heeft geleid tot verkeerde beslissingen. In het ergste geval wordt de bias niet herkend en/of kunnen de gegevens niet voldoende geneutraliseerd worden.

Er is geen gebrek aan ontspoorde trainingen en onderzoekers ontwikkelen steeds meer methoden om de oorzaken daarvan te detecteren en te visualiseren. Marco Tulio Ribeiro (Universiteit van Washington) en zijn wetenschappelijke team ontdekten met hun analyseprocedure LIME dat een kunstmatig neuraal netwerk op basis van foto’s van husky’s alleen geleerd had om sneeuw te herkennen. Een ander systeem bleef bij het leren van het concept trein volledig blind voor locomotieven en wagons. In plaats daarvan sloeg het alleen aan op perrons en sporen. Fouten die zelfs een peuter nooit zou maken. Ook daarom is het vaak zo moeilijk voor ontwikkelaars om bias in trainingsgegevens van tevoren te vermijden.

Meer AI-problemen

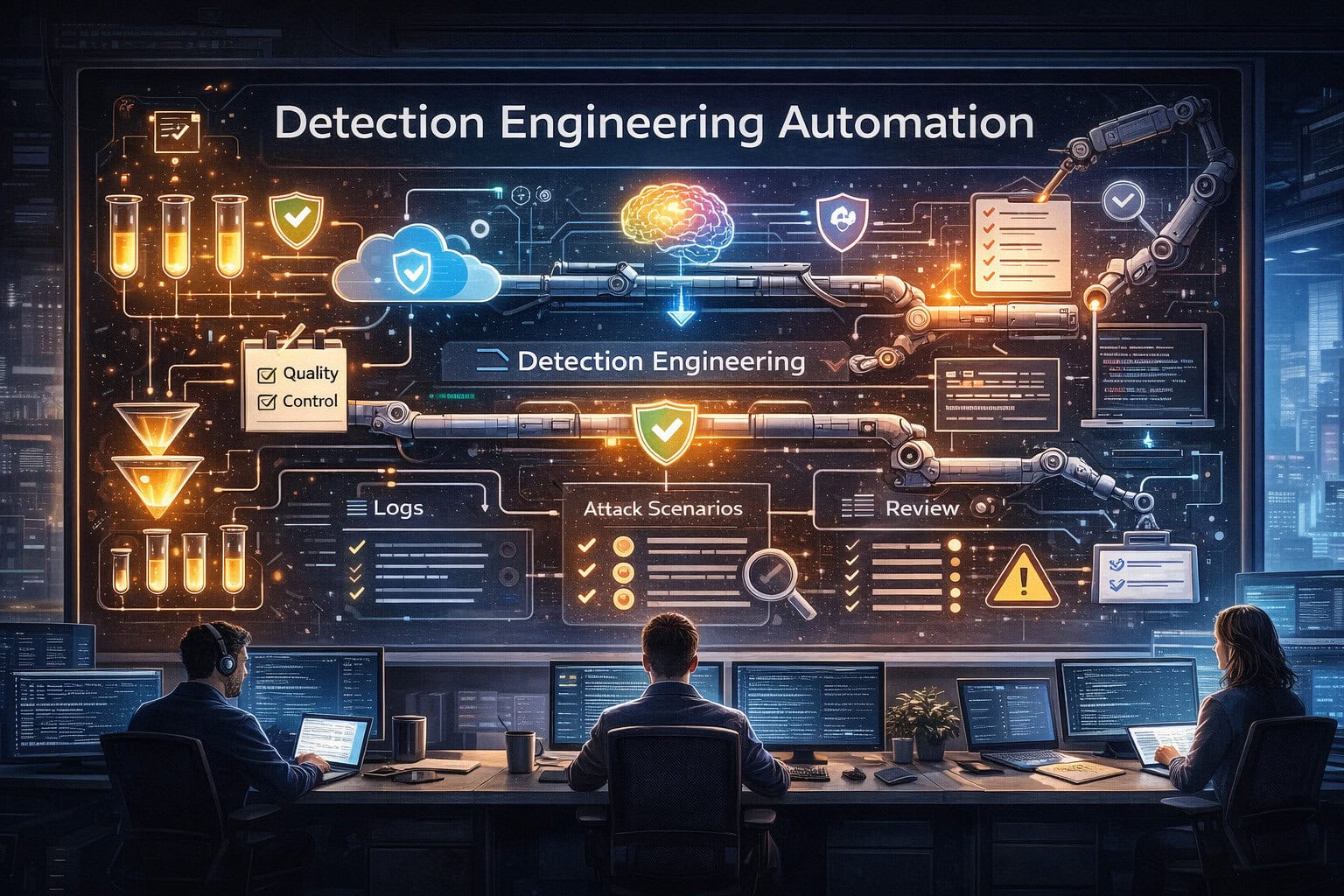

De bias is maar een van de problemen die in de praktijk voorkomen met met kunstmatige intelligentie. Ook zaken als de effectiviteit, valse positieven en ‘Adverserial Examples’ komen om de hoek kijken. Hoe de vele kleine en grote problemen ervoor kunnen zorgen dat een AI in de praktijk foutgevoelig of zelfs onbruikbaar is, lees je in onderstaande uitgave van c’t magazine. In dezelfde artikelreeks lees je ook, waarom met de huidige stand van zaken de grondbeginselen van het menselijk denken niet gesimuleerd kunnen worden.

- Dreiging door kwantumcomputers

- Beveiliging financiële sector

- Obsidian efficiënt gebruiken

- Windows-account herstellen

Tip!

Dit is het moment om jouw droomdevice aan te schaffen.

Praat mee