Complete AI-ready infrastructuur van Supermicro

Dit artikel is tot stand gekomen in samenwerking met onze partner Supermicro.

De vraag naar AI-infrastructuur blijft maar groeien: voor het trainen van de modellen zijn clusters met duizenden gpu’s nodig. Ook AI-interferentietoepassingen vereisen steeds meer rekenkracht voor het uitvoeren van meerdere inferentierondes.

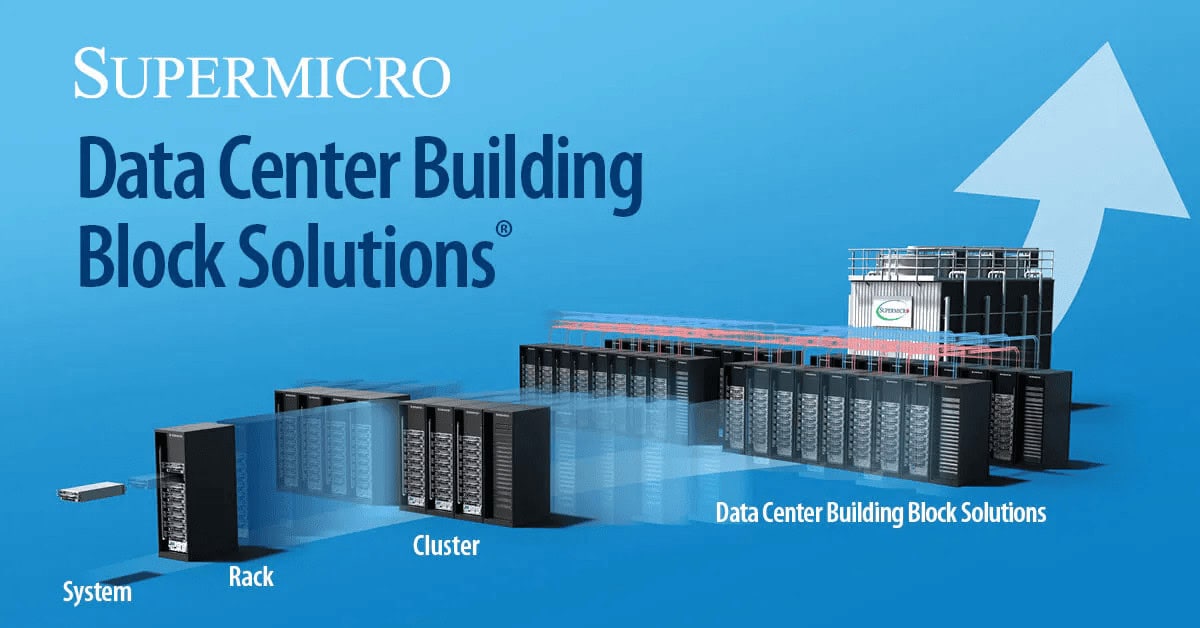

Supermicro biedt voor deze eisen een complete oplossing met Data Center Building Block Solutions (DCBBS). DCBBS is een eenvoudige oplossing voor de complexe uitdagingen die komen kijken bij het inrichten van vloeistofgekoelde AI-datacenters. De oplossing omvat alle essentiële infrastructuurcomponenten: servers, opslag, netwerken, racks, vloeistofkoeling, software, services en ondersteuning.

Vele voordelen

DCBBS biedt snelle toegang tot cutting-edge technologie en bevat de laatste gpu’s, cpu’s, interconnects, opslag, netwerk- en vloeistofkoeling-oplossingen. Directe vloeistofkoeling is zeer efficiënt in de warmte direct wegvoeren van de chips, zelfs bij AI-gpu’s met een TDP van 1000 watt of hoger. De verwachting is dat datacenters de komende jaren steeds meer overstappen op vloeistofkoeling: Supermicro verwacht dat binnen een jaar dat vloeistofkoeling in datacenters groeit van minder dan 1 procent van de markt tot 30 procent.

DCBBS biedt maximale performance en efficiëntie met ongeëvenaarde aanpasbaarheid op systeem- en rackclusterniveau, en wat de koeling en energievoorziening betreft. En dit alles helemaal op maat voor de gewenste workload en taken. Supermicro beheert de complete lifecycle voor de infrastructuur, van het ontwerp en de bouw tot de onsite deployment en support. DCBBS maakt het plannen, opbouwen en beheren van AI-datacenters eenvoudiger en dat alles tegen lagere kosten.

Het systeem kan worden uitgebreid tot maximaal 256 vloeistofgekoelde 4U Supermicro Nvidia HX-systemen met elk acht Nvidia Blackwell gpu’s (2048 stuks in totaal), onderling verbonden via Nvidia Quantum-X800 InfiniBand of het Nvidia Spectrum X-ethernetplatform, wat snelheden haalt tot 800 Gbit/s.

Succesverhaal: xAI Colossus

De grootste AI-supercomputer ter wereld wordt aangedreven door een Supermicro vloeistofgekoeld supercluster. xAI’s Colossus supercomputer is ontworpen om xAI’s Grok AI naar een hoger niveau te tillen. De supercomputer bevat 100.000 Nvidia H100-gpu’s en is in slechts 122 dagen gebouwd. De systemen voor de supercomputer bestaan uit de vloeistofgekoelde racks, samengesteld uit 4U-servers met 8 Nvidia H100-gpus met 64 gpu’s per rack.

Acht van deze gpu-servers in combinatie met een Supermicro Coolant Distribution Unit (CDU) en bijbehorende hardware vormen één van de gpu compute racks. Deze racks zijn gecombineerd in groepen van 8 voor 512 gpu’s, plus de bijbehorende netwerk-connectiviteit.

Om meerdere redenen zijn dit de meest geavanceerde AI-servers op de markt: de mate van vloeistofkoeling die is toegepast is daar een van, maar ook de mate van gemak qua beheer: er kan gewerkt worden aan de trays zonder dat de systemen uit de racks gehaald hoeven te worden.

De vloeistofkoeling maakt gebruik van snelkoppelingen, waardoor de vloeistofkoeling snel en éénhandig kan worden verwijderd of geplaatst om de trays los te halen voor onderhoud. Onderin de racks zitten de CDU’s oftewel de Coolant Distribution Units. Dit zijn een vorm van forse warmtewisselaars. Elk rack bevat een vloeistof-loop die alle gpu-servers koelt. Elke CDU heeft een redundante pomp en voeding, zodat deze vervangen kunnen worden zonder dat het complete rack uitgeschakeld hoeft te worden.

De cpu-compute nodes van de xAI supercomputer zijn opgebouwd uit 1U-servers. Een derde van de frontplaat is ingezet om koele lucht in het systeem te laten stromen, de warmtewisselaar in de achterkant van het rack haalt de warmte weg via uitwisseling van warmte met de leidingen voor vloeistofkoeling. Qua netwerk haalt elke fiberlink 400Gbit/s aan snelheid, met negen links per systeem komt dat uit op 3,6 TB/s aan bandbreedte per gpu-compute server.

Klaar voor de AI-toekomst

De geïntegreerde aanpak van Supermicro met DCBBS laat zien hoe AI-infrastructuur schaalbaar, beheersbaar en toekomstbestendig kan worden ingericht – van edge tot hyperscale datacenters.

Met modulaire bouwblokken, efficiënte vloeistofkoeling en bewezen prestaties op supercomputerschaal is Supermicro uitstekend gepositioneerd om de exponentiële groei in AI-rekenbehoeften te ondersteunen. Daarmee vormt DCBBS niet alleen een technologische basis, maar ook een strategische bouwsteen voor het AI-datacenter van morgen.

Ontdek alle mogelijkheden op de website van Supermicro of neem contact op via [email protected].

Praat mee