GIGAPOD: one-stop-oplossing voor de AI-revolutie

Lees verder na de advertentie

GIGABYTE heeft GIGAPOD geïntroduceerd, een geavanceerde AI-supercomputer infrastructuuroplossing die is ontworpen om moderne AI-toepassingen te verbeteren, zoals het trainen van grote taalmodellen (Large Language Model, LLM) en real-time inferentie. Het is gebouwd rond krachtige gpu-servers en bevat AMD Instinct MI325X-gpu’s in combinatie met AMD EPYC 9005 en 9004 series cpu’s. Door gebruik te maken van gpu-interconnects via AMD Infinity Fabric Link of RoCEv2, combineert het de nodes in een cluster tot een enkele computing-unit via high-speed networking, waardoor de cruciale mogelijkheden van high-speed parallel computing vereisten in AI-toepassingen aanzienlijk worden vergroot.

Dankzij de flexibele en schaalbare architectuur, voldoet de GIGABYTE GIGAPOD ruime en variabele mogelijkheden in ontwerp, productie en implementatie. GIGPOD is ontworpen om de explosieve groei in AI-trainingsmodellen aan te kunnen en biedt een one-stop-oplossing voor het transformeren van traditionele datacenters tot grootschalige AI-cloudserviceproviders. Door gebruik te maken van GIGABYTE’s expertise op het gebied van hardware en sterke samenwerkingsverbanden met toonaangevende upstream gpu-fabrikanten, wordt niet alleen een soepele implementatie van AI-supercomputers gegarandeerd, maar worden gebruikers ook voorzien van betrouwbare AI-productiviteit.

Tip

Met connectiviteit van Odido Business maakt Firefly verlichting slimmer, efficiënter en beter beheersbaar.

Uitdagingen in moderne computerarchitecturen

In de begintijd van gpu-toepassingen en AI-ontwikkeling, toen de computervereisten relatief laag waren en de interconnecttechnologie nog niet volwassen was, draaide gpu-computing voornamelijk op een eenvoudige architectuur met één server. Naarmate de schaal van trainingsmodellen toenam, werd het belang van multi-gpu- en multi-node-architecturen echter steeds duidelijker, vooral voor het trainen van LLM’s met honderden miljarden parameters. De gpu is belangrijk, maar de clustercomputing-interconnect mag niet over het hoofd worden gezien, omdat deze de AI-trainingstijden aanzienlijk kan verkorten en een essentieel onderdeel is geworden voor grootschalige computercentra.

Wanneer geavanceerde bedrijven ideale AI-toepassingsoplossingen bouwen, hebben ze meestal te maken met drie primaire vereisten tijdens de eerste hardware-implementatie:

Veel rekenkracht: gpu-nodes kunnen in tandem rekenen, waardoor ze efficiënt parallelle verwerkingstaken zoals matrixbewerkingen kunnen uitvoeren tijdens AI-training en simulaties.

Systematische inzet van hardware: de inzet van datacenters vereist een nauwgezette planning van belangrijke aspecten zoals stroomvoorziening, vloerindeling, rackconfiguratie en thermisch beheer, waardoor een volledige integratie van systeem-hardware wordt gegarandeerd.

Ononderbroken hogesnelheidsnetwerkarchitectuur: een snelle netwerktopologie biedt netwerkinterconnecties met een hoge bandbreedte en lage latentie om de gegevensoverdracht te versnellen en de systeemprestaties te verbeteren.

Discussies over de bouw van een datacenter draaien vaak om het aantal gpu’s en de rekenkracht, maar zonder een goed stroomvoorzienings- en koelsysteem zullen de gpu’s in de serverruimte hun potentieel niet kunnen realiseren.

Daarnaast is een snelle netwerkarchitectuur een must, omdat deze een cruciale rol speelt bij het garanderen dat elke reken-node in realtime kan communiceren, zodat een snelle gpu-naar-gpu-communicatie kan worden gerealiseerd om zo de exponentiële groei van gegevens te verwerken.

GIGAPOD: geoptimaliseerde hardware

Een basisconfiguratie van GIGAPOD met AIR/DLC-koeling bestaat uit 32 gpu-servers, die elk zijn uitgerust met 8 gpu’s, waardoor er in totaal 256 onderling verbonden gpu’s beschikbaar zijn. Daarnaast is er een speciaal rack nodig voor netwerkswitches en opslagservers, dat verantwoordelijk is voor het uitvoeren van de beheersoftware.

De GIGABYTE G893/G4L3-serie server is beschikbaar met de volgende configuratie/specificaties:

• CPU: dubbele AMD EPYC 9005/9004-serie processors • GPU: AMD Instinct MI325X GPU’s • Geheugen: 24x DDR5 DIMM’s • Opslag: 8x 2,5” Gen5 NVMe hot-swap-schijven • PCIe-slots: 4x FHHL en 8x FHHL PCIe Gen5 x16-slots • Voeding: 6+6 / 4+4 3000 W 80 PLUS Titanium redundante voedingen

Alle servermodellen in de G893/G4L3-serie ondersteunen 8-gpu baseboards en dubbele cpu’s. Bij parallelle workloads vertrouwt de server voornamelijk op de gpu, terwijl complexe lineaire verwerkingstaken worden afgehandeld door de cpu. Deze werklastverdeling is ideaal voor AI-trainingstoepassingen.

Unieke voordelen van de GIGABYTE G893/G4L3-serie:

• Rack-scale ontwerp met hoge dichtheid: De G4L3-serie biedt de industrie’s 8-GPU vloeistofgekoelde server met hoge dichtheid in een 4U-vormfactor. Met maximaal 8 x G4L3-servers per rack maximaliseert het de ruimte-efficiëntie voor grootschalige AI-implementaties.

• Aan de voorzijde gemonteerde GPU-lade: De verwijderbare GPU-lade aan de voorzijde zorgt voor eenvoudiger onderhoud en toegang tot de GPU-modules.

• Geavanceerde koeltechnologie: ondersteunt Direct Liquid Cooling (DLC) voor CPU en GPU om het energieverbruik te verminderen en een lagere PUE (Power Usage Effectiveness) te bereiken.

• 1-op-1 gebalanceerd ontwerp: elke PCIe-switch is verbonden met hetzelfde aantal GPU’s, opslagapparaten en PCIe-slots, waardoor deze ideaal is voor GPU RoCEv2 en directe gegevenstoegang vanaf NVMe-schijven.

• 6+6 / 4+4 x CRPS redundante voedingen: beschikt over een redundant voedingsontwerp, 3000 W PSU om N+N-redundantie te bereiken.

Bij het bouwen van een voor hoge prestaties geoptimaliseerde AI-computingoplossing, is het vermijden bottlenecks in de bandbreedte van cruciaal belang. In krachtige AI-systemen of clusters verloopt in het ideale geval alle gegevensoverdracht over het geheugen met een hoge bandbreedte, zodat gegevensoverdracht via de PCIe-lanes van de processor wordt vermeden. Om prestatieproblemen met bandbreedte op te lossen, integreert GIGABYTE vier Broadcom PCIe-switches op de systeemkaart, zodat gpu’s toegang hebben tot gegevens via Remote Direct Memory Access (RDMA) zonder dat ze via de cpu worden geleid. Voor versnelde netwerken maakt elke gpu verbinding met een PCIe NIC: Broadcom P1400G 1x 400G.

Daarnaast helpen PCIe-switches met signaaluitbreiding, waardoor meer I/O-connectiviteit mogelijk is door PCIe-lanes efficiënt te delen buiten de lanes die zijn toegewezen aan de gpu-modules. Het ontwerp van GIGABYTE bevat vier extra PCIe x16 slots, die vaak worden gebruikt met DPU’s en SuperNIC’s.

Schaalbare netwerkarchitectuur

Bij AI computing worden vaak grote datasets verwerkt op meerdere gedistribueerde nodes. Om het ware potentieel van een cluster te realiseren, speelt het netwerk een sleutelrol in het mogelijk maken van hoge datatransfersnelheden tussen nodes, het garanderen van synchronisatie en het behouden van dataconsistentie in het hele systeem.

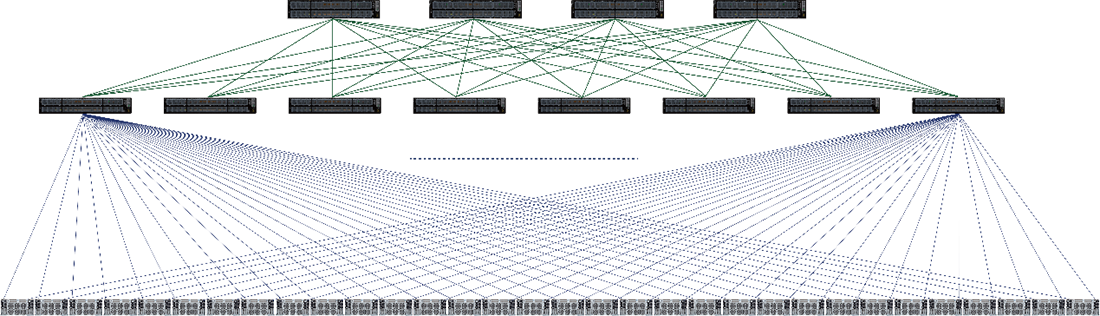

Tijdens de training van grote taalmodellen wordt de data-intensieve werklast afgehandeld door de acht gpu’s in elke server. Deze MI325X-gpu’s kunnen gegevens uitwisselen met snelheden tot 896 GB/s met behulp van Infinity Fabric-technologie, waardoor de rekenefficiëntie wordt gemaximaliseerd. De schaalbaarheid van de gegevensuitwisseling met andere gpu-nodes in het cluster wordt afgehandeld via een netwerkarchitectuur die uit meerdere switches bestaat, waarbij doorgaans gebruik wordt gemaakt van UfiSpace S9321-64E met 128 poorten en 400G-switch.

GIGAPOD netwerktopologie

Non-blocking: Elke twee punten kunnen communiceren zonder interferentie of congestie van ander verkeer. In een non-blocking netwerk is er altijd voldoende bandbreedte beschikbaar, zodat alle gegevens gelijktijdig kunnen worden verzonden zonder vertraging of knelpunten te veroorzaken.

Fat-Tree: Deze topologie maakt gebruik van een zogenaamd ‘leaf-spine’-netwerkconcept. Leaf-switches verbinden servers, terwijl spine-switches de kern van het netwerk vormen. Elke leaf-switch is verbonden met elke spine-switch in het netwerk, waardoor meerdere paden ontstaan om congestie te voorkomen en hoge prestaties en minimale latentie te garanderen. De ‘dikkere’ (fat) hogere niveaus naar de top van de boom hebben een hogere bandbreedte, waardoor prestatiebottlenecks worden vermeden. Dit maakt GIGAPOD ideaal voor schaalbare omgevingen met veel verkeer.

Een 2-tier rail-topologie: bestaat uit twee lagen leaf-spine-switches, aangeduid als Tier 1 (T1) en Tier 2 (T2). In dit ontwerp zijn T1-switches – die fungeren als leaf-switches – rechtstreeks verbonden met de netwerkinterfacekaarten (NIC’s) van elk backend-knooppunt. Elke NIC op een knooppunt is gekoppeld aan een afzonderlijke poort op elke T1-switch, wat zorgt voor redundantie en evenwichtige connectiviteit.

Een van de belangrijkste voordelen van de rail-topologie is de mogelijkheid om verkeer binnen specifieke rails te lokaliseren, waardoor de kans op congestie in het bredere netwerk wordt verkleind. Bovendien zijn communicatiebibliotheken ontworpen om rail-bewust te zijn, wat betekent dat ze datapaden kunnen optimaliseren op basis van de railstructuur en de schaalbare fabric.

Met deze concepten in gedachten kunnen we in de GIGAPOD netwerkarchitectuur duiken. In GIGAPOD wordt elke gpu in een server gekoppeld aan een NIC-kaart, wat 8 gpu-NIC-paren per server oplevert. Elk gpu-NIC-paar in een server is verbonden met een andere leaf-switch in de middelste laag. Gpu-NIC-paar #1 van gpu server #1 wordt bijvoorbeeld verbonden met leaf-switch #1, en gpu-NIC-paar #1 van gpu-server #2 wordt verbonden met dezelfde leaf-switch #1.

Vervolgens worden de leaf- en spine-switches verbonden om een fat-tree te vormen. Deze uitbreiding naar de toplaag volgt een gelijkaardig concept als het verbinden van servers met leaf-switches. Poorten van elke bladschakelaar worden gelijkmatig verdeeld over de spine-switches, waardoor een top-layernetwerk wordt gevormd.

Samengevat bestaat een schaalbare GIGAPOD-unit uit 32x gpu-servers en twaalf switches, waarvan er vier dienen als spine-switches en acht als leaf-switches, allemaal verbonden en beheerd via 256x NIC-kaarten om elke gpu te orkestreren. Hieronder staat een voorbeeld van de specificaties:

• 4x UfiSpace S9321-64E spine-switches (bovenste laag) met QSFP-DD, 800G, 2x400Gb/s DR4-transceivers • 8x UfiSpace S9321-64E Leaf-switches (middelste laag) met QSFP-DD, 800G, 2x400Gb/s DR4-transceivers • Elke server heeft 8 Broadcom P1400G NIC’s (onderste laag) met QSFP56-DD, 400Gb/s DR4-transceivers • MPO-12/APC SMF passieve glasvezelkabels

GIGAPOD: complete AI-oplossing op rackniveau

Na de systeemconfiguratie en netwerktopologie is rackintegratie de laatste stap bij de implementatie van GIGAPOD. Naast het aantal racks en node-configuraties is het essentieel om een geoptimaliseerd bekabelingsontwerp te overwegen om de kosteneffectiviteit te maximaliseren. Belangrijke factoren voor rackintegratie zijn onder andere:

- Optimaliseren van de kabellengte om kabelspaghetti te voorkomen en overtollige lengte en onnodige kosten te beperken

- Maximaliseren van ruimtegebruik om de dichtheid van apparatuur te verhogen

- Koeling verbeteren om betere prestaties te behalen en warmte effectief af te voeren

- Stroomlijnen van installatie en instelling voor een vereenvoudigde, efficiënte inzet

- Het leveren van aftermarket-diensten voor onderhoudsgemak en schaalbaarheid

Deze uitgebreide aanpak zorgt ervoor dat GIGAPOD krachtige en schaalbare AI-oplossingen levert met een efficiënte implementatie en beheer.

Met de voortdurende vooruitgang in cpu- en gpu-technologie, samen met de wereldwijde nadruk op groen computergebruik, is thermisch beheer een belangrijke factor geworden in het ontwerp en de infrastructuur van datacenters.

Voor klanten die rekenkracht willen maximaliseren binnen hun bestaande datacenterruimte, heeft GIGAPOD een ontwerp voor directe vloeistofkoeling dat de perfecte oplossing vormt. GIGABYTE gebruikt een 8-gpu-platform in een 4U-chassis, waarbij zowel cpu’s als gpu’s zijn uitgerust met DLC-koelplaten. Warmte wordt effectief afgevoerd van de chips via passieve vloeistofkoeling, wat zorgt voor topprestaties en energiezuinigheid.

Door het verwijderen van koellichamen en enkele ventilatoren, en door het geoptimaliseerde thermisch ontwerp, wordt er bovendien ruimte vrijgemaakt. Hierdoor kan GIGAPOD een configuratie met half zoveel computerracks realiseren in vergelijking met luchtkoeling. Slechts vier racks met vloeistofkoeling kunnen dezelfde prestaties leveren als de oorspronkelijke configuratie met luchtkoeling met acht racks, waardoor de ruimte in het datacenter maximaal wordt benut.

Uitgebreid implementatieproces

Een enkele schaalbare GIGAPOD-unit met 32 gpu-servers vereist meer dan 20.000 onderdelen om te voltooien, dus er is een zeer systematisch proces nodig om ervoor te zorgen dat elke fase soepel verloopt. Van advies tot daadwerkelijke implementatie gebruikt GIGABYTE een proces in vijf stappen om ervoor te zorgen dat GIGAPOD van begin tot eind succesvol wordt gebouwd en geleverd.

Het hele proces omvat talloze gedetailleerde besprekingen, zoals de voedingsconfiguratie van GIGAPOD. Voor de luchtgekoelde versie van GIGAPOD vereist elk rack ondersteuning voor 66 kW stroom voor de hardware, waaronder vier gpu-servers, switches en andere componenten. Om dit aan te pakken, kiest GIGABYTE voor de IEC60309 100A 380V- voedingsstekker en levert het een redundant ontwerp met twee sets PDU’s (Power Distribution Units) per rack. Omdat bij de vloeistofkoelingsoplossing de dichtheid in het rack verdubbelt, neemt de stroombehoefte toe tot 100 kW per rack, waarbij een 2+2 PDU-configuratie wordt gebruikt.

GIGAPOD ondersteunt ook twee soorten stopcontacten, C19/C20 of Anderson, zodat klanten de oplossing kunnen kiezen die het beste bij hun behoeften past. Bovendien kunnen de stroomvereisten voor datacenters, zoals het type AC-ingang, variëren op basis van geografische locatie en andere factoren. Het GIGABYTE-team blijft dus zeer flexibel en evalueert regionale omgevingsfactoren om de best mogelijke oplossing te bieden.

AI-gestuurde software- en hardware-integratie

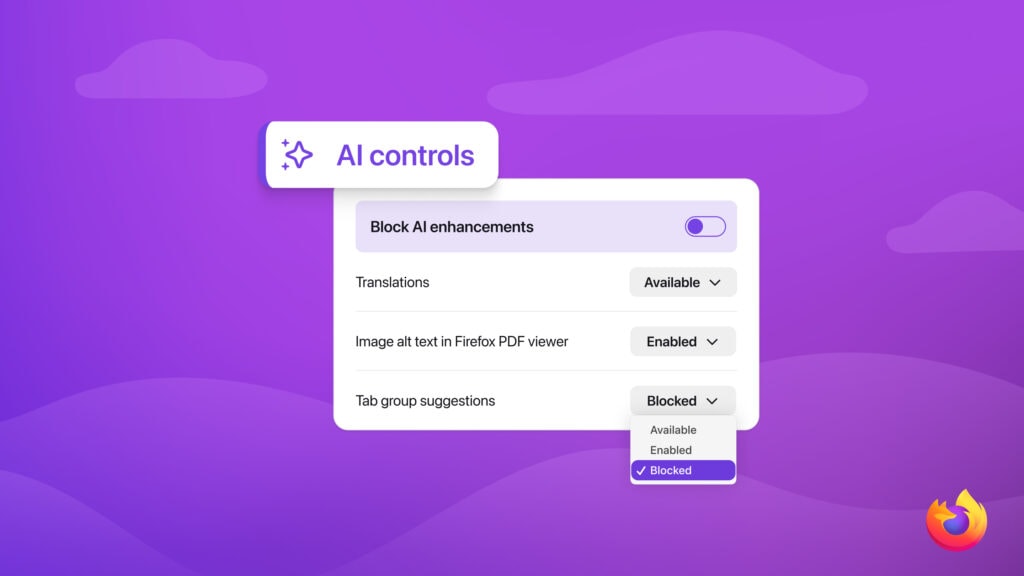

Om de complexe behoeften van AI-gedreven ondernemingen te ondersteunen, is GIGAPOD gekoppeld aan het GIGAPOD Management Platform (GPM), dat een uniforme onderhoudsinterface biedt voor apparaten in het hele cluster, waaronder servers, netwerken, opslag, voeding en koeling. Hierdoor kunnen bedrijven op grote schaal alle IT-hardware in clusters bewaken, onderhouden en beheren.

GPM ondersteunt integratie met het Juju-platform van Canonical en beschikt ook over een geautomatiseerde inzet van taakplanningssoftware zoals Canonical Charmed Kubernetes, wat gebruikers flexibiliteit geeft in het beheren van gpu-servers met verschillende architecturen. Door onze samenwerking met AMD en Canonical combineert GIGABYTE geavanceerde hardware met krachtige softwaretools om een end-to-end, schaalbaar AI-infrastructuurbeheerplatform te leveren.

Een andere manier om het cluster te verbeteren is het gebruik van MLSteam van Myelintek, een MLOps-platform. Met MLSteam kunnen AI R&D-teams zich meer richten op hun expertisegebieden zonder extra tijd en kosten te besteden aan het bouwen van ontwikkelomgevingen. Het maakt ook effectief beheer van trainingsdata en -modellen mogelijk, inclusief data-annotatie, modelontwikkeling, model-serving en model-retraining, waardoor AI-levenscyclusbeheer wordt gerealiseerd.

GPM en GIGABYTE high-performance GPU-servers ondersteunen verschillende versnellers en voldoen daarmee aan de software- en hardware-architectuurvereisten voor AI R&D-teams.

Conclusie

GIGAPOD, GIGABYTE’s AI-supercomputeroplossing voor datacenters, blinkt niet alleen uit in betrouwbaarheid, beschikbaarheid en onderhoudsgemak, maar biedt ook ongeëvenaarde flexibiliteit. Of het nu gaat om de keuze van gpu, rackgrootte, koeloplossingen of planning op maat, GIGABYTE past zich aan de verschillende IT-infrastructuren, hardwarevereisten en datacentergroottes aan.

Met service-levels die variëren van L6 tot L12 en alles omvatten van het ontwerp van de voedings- en koelinfrastructuur tot de inzet van hardware, systeemoptimalisatie en after-sales ondersteuning, zorgen we ervoor dat onze klanten een end-to-end-oplossing ontvangen die volledig voldoet aan hun operationele vereisten en prestatiedoelen.

Tip!

Dit is het moment om jouw droomdevice aan te schaffen.

- Uitdagingen in moderne computerarchitecturen

- GIGAPOD: geoptimaliseerde hardware

- Unieke voordelen van de GIGABYTE G893/G4L3-serie:

- Schaalbare netwerkarchitectuur

- GIGAPOD netwerktopologie

- GIGAPOD: complete AI-oplossing op rackniveau

- Uitgebreid implementatieproces

- AI-gestuurde software- en hardware-integratie

- Conclusie

Praat mee