Model Context Protocol (MCP): koppel AI aan apps en data

Met het Model Context Protocol kun je AI-taalmodellen realtime verbinden met apps en data. Nu al kunnen ChatGPT & Co. zelfstandig duizenden apps bedienen, van browsers en zakelijke apps tot Spotify en het smarthome. Dat biedt talloze nieuwe mogelijkheden, maar herbergt ook risico’s. Ontdek wat MCP voor de inzet van AI betekent.

Lees verder na de advertentie

AI verbinden met de buitenwereld

AI-taalmodellen worden agents. Ze nemen zelfstandig beslissingen, hebben interactie met gegevens en besturen tools om taken uit te voeren. Deze AI-agents waren een van de belangrijkste onderwerpen op de ontwikkelaarsconferentie I/O van Google. Het bedrijf wil bijvoorbeeld zijn zoekmachine opleuken met AI op basis van agents.

Windows-gebruikers kunnen binnenkort AI-agents vinden in hun besturingssysteem, want Microsoft bouwt dergelijke helpers bij Windows in. In plaats van zelf door toepassingen te moeten klikken, zullen gebruikers in de toekomst hun pc gewoon vertellen wat ze willen dat hij doet. De pc voert dan de taken uit door geïnstalleerde toepassingen aan te sturen en toegang te krijgen tot het bestandssysteem en webservices.

Tip

Met connectiviteit van Odido Business maakt Firefly verlichting slimmer, efficiënter en beter beheersbaar.

Een belangrijke technologie die dit mogelijk maakt is het Model Context Protocol (MCP). Lees hier wat erachter zit en waarom MCP de toepassingsmogelijkheden voor taalmodellen aanzienlijk uitbreidt. In c’t 11/2025 laten we verder voorbeelden zien van het gebruik van MCP, hoe je je eigen MCP-server kunt programmeren en bespreken we de beveiligingsproblemen in detail.

Altijd op de hoogte van kunstmatige intelligentie?

Context is alles

Om de voordelen van het Model Context Protocol te begrijpen, is het nuttig om de snelle evolutie van taalmodellen te bekijken. In hun oorspronkelijke vorm zijn taalmodellen niet meer dan tekstgeneratoren die beperkt zijn tot de kennis die ze hebben geleerd. Hoewel ze complexe teksten kunnen genereren en analyseren, hebben ze geen toegang tot actuele informatie en externe gegevensbronnen. In het geval van specifieke, actuele of contextafhankelijke informatie geven ze geen antwoord of gaan ze soms hallucineren. Ze kunnen al helemaal geen externe diensten of toepassingen aansturen.

In de afgelopen jaren zijn er nieuwe mogelijkheden toegevoegd aan deze tekstmachines. Retrieval Augmented Generation (RAG) bijvoorbeeld combineert taalmodellen met externe kennisdatabases. Wanneer een zoekopdracht naar een taalmodel wordt gestuurd, worden eerst relevante documenten of tekstpassages opgehaald en als context aan het taalmodel verstrekt. Hierdoor heeft het toegang tot actuele of domein-specifieke informatie zonder opnieuw te hoeven worden getraind.

Function calling gaat nog een stap verder. Het stelt taalmodellen in staat om zelfstandig externe apps en diensten aan te sturen. Hiervoor moet het model worden voorzien van een lijst met beschikbare functies van de betreffende applicatie die moet worden aangestuurd, inclusief hun parameters en beschrijvingen. Dit is op elk moment mogelijk en vereist geen hertraining. Function calling verandert taalmodellen van pure tekstjongleurs in actieve agents die interacteren met de digitale omgeving.

Elke aanbieder van taalmodellen (OpenAI, Anthropic, Google, etc.) heeft echter zijn eigen programmeerinterfaces en implementatiebenaderingen voor function calling. Dit heeft geleid tot een gefragmenteerd landschap. Ontwikkelaars moeten voor elk taalmodel hun eigen functiedefinities en aanroepmechanismen implementeren.

USB-C voor taalmodellen

MCP is het antwoord op dit probleem. Het biedt een gestandaardiseerd protocol dat werkt voor alle taalmodellen en tools. Ontwikkelaars hoeven de interface naar hun eigen applicaties – of dat nu databases, API’s of lokale tools zijn – maar één keer te implementeren als een zogenaamde MCP-server. Verschillende AI-modellen kunnen hier vervolgens mee interageren. Dit vermindert de ontwikkelingsinspanning aanzienlijk. MCP wordt daarom vaak de ‘USB-C standaard’ voor AI tools genoemd – eenmaal geïmplementeerd kan het overal worden gebruikt.

Anthropic introduceerde het Model Context Protocol pas in november 2024. De wereld leek te hebben gewacht op iets als MCP, want het vestigde zich al snel als een quasi-standaard in de industrie. OpenAI, Google en Microsoft hebben recent aangekondigd MCP te ondersteunen. Er zijn al duizenden MCP-servers voor een breed scala aan applicaties en diensten.

Hoe MCP werkt

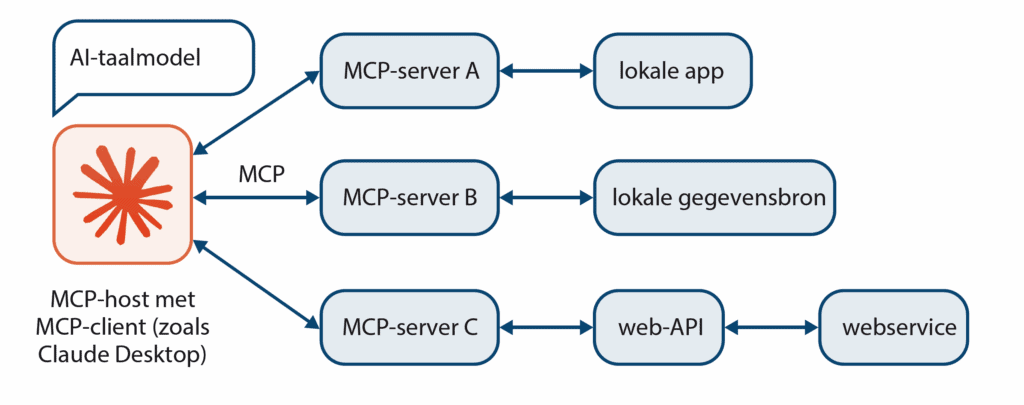

MCP is gebaseerd op een client-serverarchitectuur die met opzet eenvoudig is gehouden. Er zijn drie hoofdrolspelers. De MCP-host is de belangrijkste component die MCP-functies integreert in een groter systeem. De host beheert de verbindingen met de MCP-servers en maakt hun functies beschikbaar voor het taalmodel. De desktopapplicatie van Claude is een voorbeeld van een MCP-host, maar programmeeromgevingen en applicaties voor zakelijk gebruik kunnen ook MCP-hosts zijn. De MCP-client is de technische implementatie binnen de host die de communicatie op laag niveau met de MCP-servers afhandelt.

MCP-servers zijn de adapters tussen AI-systemen en specifieke apps, gegevensbronnen of API’s. Een MCP-server kan bijvoorbeeld een database bevragen, een andere kan e-mails versturen en een derde heeft toegang tot agendagegevens. De AI kan al deze servers in combinatie gebruiken om complexe taken uit te voeren.

Server en client sturen elkaar JSON-snippets in JSON-RPC 2.0-formaat. Hoe deze eruit zien beschijven we in detail in c’t 11/2025. Een centraal concept van MCP is ‘capabilities’. Dit zijn duidelijk gedefinieerde mogelijkheden die een server biedt.

Tools en resources

Elke MCP-server kan drie soorten van deze mogelijkheden bieden. In MCP-terminologie zijn ‘tools’ acties die kunnen worden uitgevoerd, zoals ‘e-mail verzenden’ of ‘bestand maken’. Tools kunnen iets in de echte wereld veranderen (bijvoorbeeld in een database of in een smarthome), of iets berekenen.

Daarnaast zijn er ‘resources’, die MCP beschouwt als inhoud die gelezen kan worden, zoals documenten, database-items of API-reacties. In tegenstelling tot tools, mag hun aanroep niets veranderen. Tot slot zijn er ‘prompts’: kant-en-klare tekstfragmenten die dienen als sjablonen voor veelvoorkomende verzoeken. Een GitHub-server zou bijvoorbeeld tools kunnen bieden voor het aanmaken van issues, resources voor het lezen van repository’s en prompts voor typische workflows van ontwikkelaars.

Flexibiliteit

Zodra een MCP-client verbinding maakt met een MCP-server, vraagt hij welke functies de server aanbiedt. De server antwoordt met een gedetailleerde lijst van zijn mogelijkheden, inclusief hun beschrijvingen en vereiste parameters. Deze zelfopenbaring maakt het systeem flexibel.

Nieuwe servers kunnen worden toegevoegd zonder dat bestaande clients hoeven te worden aangepast, omdat ze automatisch leren hoe ze met de nieuwe functies moeten omgaan als de verbinding tot stand wordt gebracht.

De JSON-berichten kunnen via twee transportroutes worden verzonden. Lokaal draaiende MCP-servers bijvoorbeeld, die iets moeten doen op je eigen computer, starten als child-proces van de client en communiceren via de standaard Stdin- en Stdout-interfaces. MCP-servers kunnen echter ook via HTTP worden gepubliceerd in het lokale netwerk of op internet en daar verschillende clients bedienen.

Snel groeiend ecosysteem

Het MCP-ecosysteem heeft zich verrassend snel ontwikkeld. Er is al een indrukwekkende verscheidenheid aan hosts en servers. De AI-assistent Claude Desktop, die beschikbaar is voor Windows en macOS (in de documentatie staat dat Linux ‘nog niet wordt ondersteund’), is de meest prominente host-toepassing. Ontwikkelomgevingen zoals Visual Studio Code, Cursor en Zed kunnen zich ook al richten tot MCP-servers om debugging- of Git-taken te automatiseren.

Als het gaat om MCP-servers die apps en diensten bestuurbaar maken via AI, is de keuze al bijna onhanteerbaar. Anthropic biedt zelf kant-en-klare MCP-servers voor populaire zakelijke diensten zoals Google Drive, Slack, Git, Postgres en Puppeteer. Veel bedrijven hebben MCP-servers uitgebracht voor hun eigen diensten, waaronder GitHub, Hugging Face, Notion, Atlassian, Stripe en Paypal.

Daarnaast heeft de ontwikkelaarsgemeenschap duizenden andere servers uitgebracht. Directories zoals het MCP Archive bieden een overzicht. Een compleet ecosysteem dat bijvoorbeeld ook verhindert dat MCP-servers met kwade bedoelingen verspreid worden, bestaat echter nog niet.

MCP: zo besturen AI-agents apps en services

Het Model Context Protocol (MCP) specificeert een gestandaardiseerde manier waarop AI-taalmodellen (Large Language Model, LLM) toegang kunnen krijgen tot lokale apps en gegevens, en ook tot webservices. De MCP-client (meestal geïntegreerd in de MCP-host) gebruikt de MCP-server om uit te zoeken welke functies beschikbaar zijn en biedt deze aan het taalmodel aan. Als het taalmodel een van de functies wil gebruiken, wordt deze aangeroepen op de MCP-server. Deze zorgt ervoor dat de app of webservice op de juiste manier wordt aangesproken, of leest de gevraagde gegevens direct in. Vervolgens geeft het feedback via de MCP-host aan het taalmodel, dat dan verdere stappen kan plannen.

Werk in uitvoering

Hoewel MCP nog zo jong is, heeft de ontwikkelaarsgemeenschap zich op de standaard gestort en laat met veel spannende projecten zien dat het mogelijk is om zeer veelzijdige en krachtige MCP-applicaties te bouwen. Als je nu aan de slag wilt, moet je er wel rekening mee houden dat MCP nog lang geen in steen gebeitelde standaard is. Dit blijkt al uit het feit dat Anthropic het oorspronkelijke ontwerp meerdere keren heeft uitgebreid.

Het ontwerp dat in november vorig jaar werd gepresenteerd, beschrijft in wezen de client-server architectuur van MCP. Het lijkt erop dat niemand nog heeft nagedacht over de beveiliging. De tweede versie van de standaard heeft onder andere zogenaamde JSON-RPC-batching geïntroduceerd. Hierdoor kan een client meerdere remote procedure calls (RPC) bundelen in een enkel netwerkverzoek in plaats van ze afzonderlijk te verzenden. Dit zou prestatievoordelen moeten opleveren.

RPC-batching is een voorbeeld van hoe dingen snel kunnen veranderen in de MCP-wereld. Anthropic heeft deze functie weer verwijderd in de recente, derde MCP-versie van juni.

Meer dan MCP: A2A en NLWeb

Naast de innovaties van Anthropic doen ook andere internetbedrijven voorstellen met betrekking tot MCP. In april ontwikkelden Google en zijn partners het Agent-to-Agent protocol (A2A) expliciet als aanvulling op MCP. Terwijl MCP zich richt op de verbinding tussen AI-agents en externe tools of gegevensbronnen, richt A2A zich op communicatie en samenwerking tussen verschillende AI-agents.

A2A stelt agents in staat om elkaar te ontdekken, berichten uit te wisselen en taken te delegeren. Hiervoor presenteren ze ‘agent cards’ aan andere agents om hun vaardigheden te adverteren. Beide protocollen kunnen elkaar aanvullen. Een agent zou MCP kunnen gebruiken om toegang te krijgen tot tools en A2A om te communiceren met andere gespecialiseerde agents. Een reisplanner kan A2A bijvoorbeeld gebruiken om te communiceren met agents van luchtvaartmaatschappijen, hotels en autoverhuurbedrijven die experts zijn in hun respectieve domeinen. In juni droeg Google de verdere ontwikkeling van A2A over aan de Linux Foundation om de leveranciersonafhankelijkheid te behouden.

Microsoft daarentegen presenteerde NLWeb (Natural Language Web). Dat is bedoeld om websites om te zetten in AI-ondersteunde toepassingen. Elke NLWeb-website functioneert ook als MCP-server, waardoor websites via natuurlijke taal toegankelijk worden voor zowel menselijke gebruikers als AI-agents.

Microsoft ziet MCP en NLWeb als de basisbouwstenen van een nieuw ‘agentic web’, vergelijkbaar met TCP/IP en HTML voor het gewone web. Terwijl MCP de communicatie tussen AI en tools regelt, maakt NLWeb webinhoud begrijpelijk voor AI-agents.

Microsoft integreert deze technologie consequent in zijn hele productassortiment, van het ontwikkelplatform GitHub tot de zakelijke software Dynamics 365 en Windows 11. Het doel is duidelijk: Microsoft wil het toonaangevende platform worden voor multi-agentsystemen waarop verschillende AI-agents samenwerken.

Mogelijke problemen

Hoewel Anthropic de beveiligingsfuncties van MCP uitbreidt, herbergt de technologie nog steeds veel risico’s. Dat komt door de basisarchitectuur: AI-modellen krijgen directe toegang tot externe systemen en kunnen daar code uitvoeren of gegevens manipuleren. Vooral promptinjecties, die aanvallers kunnen gebruiken om AI-agents te manipuleren, zijn problematisch.

Een tweede kritiek probleem ligt in autorisatiebeheer en vertrouwen tussen componenten. Hosts moeten expliciet toestemming krijgen van de gebruiker voordat ze tools aanroepen. Gebruikers moeten daarom begrijpen wat elke tool doet voordat ze het gebruik ervan autoriseren.

In de praktijk is dit echter lastig: AI-modellen kunnen tientallen tool-aanroepen genereren in complexe workflows, terwijl gebruikers onmogelijk elke aanroep kunnen beoordelen. Het is daarom erg verleidelijk om de AI algemene autorisatie te geven. In c’t 11/2025 gaan we uitgebreid in op de beveiligingsrisico’s van MCP.

Onvermijdelijke voortgang

Ondanks alle risico’s is één ding duidelijk: MCP is niet meer te stoppen. Het potentieel is te groot, de praktische voordelen te verleidelijk. Wie wil er nu geen tijdrovende of vervelende taken delegeren aan AI? De geest is uit de fles – en hij maakt zichzelf al nuttig. We zullen de ontwikkelingen dan ook zeker (kritisch) blijven volgen.

Altijd op de hoogte van kunstmatige intelligentie?

Tip!

Dit is het moment om jouw droomdevice aan te schaffen.

Praat mee